Trong bối cảnh dữ liệu ngày càng bùng nổ về khối lượng và sự đa dạng, các tổ chức doanh nghiệp phải đối mặt với thách thức lớn trong việc cân bằng giữa chi phí lưu trữ khổng lồ và nhu cầu phân tích tốc độ cao, đáng tin cậy. Sự ra đời của kiến trúc Data Lakehouse là một bước tiến mang tính chuyển đổi, đại diện cho thế hệ quản lý dữ liệu hiện đại, giải quyết triệt để những mâu thuẫn cố hữu của các mô hình tiền nhiệm.

Vậy Data Lakehouse là gì? Có những ứng dụng nào thường gặp trong doanh nghiệp? Hãy cùng FOXAI tìm hiểu trong bài viết dưới đây nhé!

Giới thiệu chung về Data Lakehouse

Data Lakehouse là gì?

Data Lakehouse là một kiến trúc quản lý dữ liệu thống nhất, được thiết kế để kết hợp các ưu điểm tốt nhất của Data Lake (Hồ dữ liệu) và Data Warehouse (Kho dữ liệu). Mục tiêu cốt lõi của kiến trúc này là cung cấp một nền tảng duy nhất cho phép lưu trữ và phân tích hiệu quả cả dữ liệu có cấu trúc lẫn dữ liệu không có cấu trúc, hỗ trợ toàn bộ chu trình từ thu thập dữ liệu linh hoạt, phân tích nâng cao cho đến học máy.

Kiến trúc Data Lakehouse ra đời để khắc phục những điểm yếu cốt lõi của các mô hình dữ liệu lịch sử :

Data Lake: Mặc dù cung cấp khả năng lưu trữ dữ liệu thô với chi phí thấp và khả năng mở rộng gần như vô hạn, Data Lake thường thiếu các tính năng quản lý chất lượng dữ liệu và các giao dịch đáng tin cậy. Điều này khiến việc phân tích trực tiếp dữ liệu phức tạp hoặc xây dựng các ứng dụng BI truyền thống trở nên khó khăn.

Data Warehouse: DW được tối ưu hóa cho phân tích kinh doanh (BI), hỗ trợ truy vấn SQL mạnh mẽ với tốc độ cao. Tuy nhiên, DW lại kém linh hoạt đối với dữ liệu phi cấu trúc và bán cấu trúc, đồng thời đi kèm với chi phí lưu trữ và tính toán rất đắt đỏ.

Data Lakehouse xuất hiện như một “cây cầu” chiến lược, cung cấp một kho lưu trữ duy nhất để phục vụ mọi nhu cầu dữ liệu của doanh nghiệp, loại bỏ sự cần thiết phải sao chép dữ liệu giữa các hệ thống chuyên biệt.

Việc phân mảnh dữ liệu (Data Silos) và quy trình ETL phức tạp yêu cầu sao chép và chuyển đổi dữ liệu nhiều lần từ Data Lake sang Data Warehouse để phục vụ các nhóm phân tích BI là động lực kinh tế chính thúc đẩy sự phát triển của Data Lakehouse. Khi dữ liệu phải được di chuyển và xử lý qua nhiều bước (ETL/ELT), nó làm tăng chi phí lưu trữ, độ trễ và rủi ro về tính nhất quán. Bằng cách loại bỏ sự sao chép dữ liệu, Lakehouse cho phép truy cập trực tiếp vào dữ liệu nguồn đã được chuẩn hóa, tăng hiệu quả sử dụng dữ liệu ngay từ nguồn.

Đặc điểm của Data Lakehouse

Để đạt được sự hợp nhất giữa tính linh hoạt của Data Lake và độ tin cậy của Data Warehouse, kiến trúc Data Lakehouse đã áp dụng các tính năng quản lý dữ liệu cấp doanh nghiệp, thông qua các lớp công nghệ tiên tiến:

Hỗ trợ giao dịch ACID (Atomicity, Consistency, Isolation, Durability)

Đây là đặc điểm kỹ thuật quan trọng nhất, đảm bảo tính toàn vẹn và đáng tin cậy của dữ liệu, ngay cả khi xử lý các luồng dữ liệu lớn hoặc truy cập đồng thời từ nhiều ứng dụng khác nhau.

Atomicity (Tính nguyên tử): Đảm bảo rằng mỗi giao dịch (đọc, ghi, cập nhật, xóa) được coi là một đơn vị công việc duy nhất. Hoặc toàn bộ giao dịch được thực hiện thành công, hoặc không có gì được thực hiện cả, ngăn ngừa mất mát hoặc hỏng hóc dữ liệu nếu nguồn dữ liệu gặp lỗi giữa chừng.

Consistency (Tính nhất quán): Đảm bảo rằng các giao dịch chỉ thực hiện thay đổi theo những cách đã được xác định trước, ngăn ngừa các lỗi hoặc hỏng hóc trong dữ liệu tạo ra hậu quả không mong muốn đối với tính toàn vẹn của bảng.

Isolation (Tính cô lập): Khi nhiều người dùng đọc và ghi đồng thời vào cùng một bảng, tính cô lập đảm bảo các giao dịch không can thiệp hoặc ảnh hưởng đến nhau. Mỗi yêu cầu có thể xảy ra như thể chúng đang xảy ra lần lượt, ngay cả khi chúng thực sự diễn ra đồng thời.

Durability (Tính bền vững): Đảm bảo rằng những thay đổi đối với dữ liệu đã được thực hiện bởi các giao dịch thành công sẽ được lưu trữ vĩnh viễn, ngay cả trong trường hợp hệ thống gặp sự cố.

Quản lý lược đồ (Schema Management)

Data Lakehouse hỗ trợ quản lý lược đồ nghiêm ngặt để đảm bảo chất lượng dữ liệu đi vào. Đồng thời, nó cũng cho phép phát triển lược đồ một cách linh hoạt, xử lý các thay đổi cấu trúc dữ liệu theo thời gian mà không làm gián đoạn các đường ống phân tích hiện có.

Tách rời lưu trữ và tính toán

Kiến trúc này tận dụng lợi thế của Object Storage (ví dụ: Amazon S3, Azure Blob Storage) để lưu trữ dữ liệu ở định dạng Columnar (Parquet, ORC, Avro). Điều này cho phép mở rộng khả năng lưu trữ với chi phí thấp một cách gần như không giới hạn. Các công cụ tính toán như Apache Spark, Trino, hoặc Presto được tách biệt, cho phép mở rộng độc lập và tối ưu hóa chi phí vận hành.

Khả năng truy cập trực tiếp

Một đặc điểm quan trọng là các ứng dụng phân tích kinh doanh (BI) có thể truy cập trực tiếp vào dữ liệu nguồn đã được chuẩn hóa trong Data Lakehouse mà không cần sao chép dữ liệu sang một kho dữ liệu riêng biệt. Điều này không chỉ giảm thiểu tình trạng trùng lặp dữ liệu mà còn tăng hiệu quả sử dụng dữ liệu và giảm độ trễ phân tích.

Những đặc điểm kỹ thuật cốt lõi này, đặc biệt là khả năng hỗ trợ giao dịch ACID và quản lý lược đồ, được cung cấp bởi Lớp Siêu dữ liệu, thường được triển khai thông qua các Định dạng bảng Mở (Open Table Formats – OTFs) như Delta Lake, Apache Iceberg và Apache Hudi. Lớp này quản lý lịch sử giao dịch và siêu dữ liệu tệp, biến kho lưu trữ thô thành các bảng logic có khả năng truy vấn và khám phá dữ liệu hiệu quả.

Tầm quan trọng của Data Lakehouse trong doanh nghiệp

Data Lakehouse không chỉ là một cải tiến về công nghệ mà còn là một chiến lược kinh doanh toàn diện, cung cấp lợi thế cạnh tranh thiết yếu trong kỷ nguyên số hóa và trí tuệ nhân tạo (AI).

Nền tảng thống nhất cho phân tích và AI

Data Lakehouse cung cấp một kho lưu trữ duy nhất, tích hợp, cho phép các kỹ sư BI, nhà khoa học dữ liệu, và kỹ sư AI làm việc trên cùng một tập dữ liệu đã được làm sạch và quản lý. Sự thống nhất này cải thiện đáng kể hiệu quả vận hành và hỗ trợ nhiều trường hợp sử dụng phức tạp cùng lúc (BI, báo cáo, phân tích nâng cao, AI/ML). Data Lakehouse đặc biệt tương thích với AI, vì nó cung cấp dữ liệu chất lượng cao, mới nhất và đa dạng cần thiết cho việc huấn luyện mô hình học máy và xây dựng các ứng dụng AI tạo sinh (Gen AI).

Đơn giản hóa quản trị dữ liệu hợp nhất

Bằng cách loại bỏ sự cần thiết của nhiều hệ thống dữ liệu riêng biệt, Lakehouse giảm thiểu tình trạng phân mảnh và phức tạp của quy trình ETL/ELT. Trên một nền tảng duy nhất, tổ chức có thể thực thi các chính sách kiểm soát truy cập, kiểm toán, theo dõi nguồn gốc dữ liệu và đảm bảo tuân thủ một cách nhất quán trên tất cả các tài sản dữ liệu, bất kể khối lượng công việc.

Xu hướng và tốc độ áp dụng thị trường

Thị trường Data Lakehouse đang trải qua sự tăng trưởng mạnh mẽ, phản ánh nhu cầu cấp thiết về nền tảng dữ liệu thống nhất. Thị trường toàn cầu được ước tính đạt USD 11.35 tỷ vào năm 2024 và dự kiến tăng trưởng với Tốc độ Tăng trưởng Kép Hàng năm (CAGR) là 23.2% từ năm 2025 đến 2033, đạt USD 74.00 tỷ vào năm 2033. Khu vực Bắc Mỹ đang dẫn đầu thị trường này với thị phần lớn nhất.

Năm 2022, 66% các tổ chức được khảo sát đã sử dụng kiến trúc Data Lakehouse, với lý do hàng đầu là cải thiện chất lượng dữ liệu. Dự báo cho thấy đến năm 2026, 60% các doanh nghiệp sẽ áp dụng giải pháp Data Lakehouse để kích hoạt phân tích thời gian thực và đơn giản hóa quản lý dữ liệu, chứng minh Data Lakehouse đang nhanh chóng trở thành tiêu chuẩn cho quản lý dữ liệu hiện đại.

Nhu cầu khai thác dữ liệu phi cấu trúc cho AI, đồng thời duy trì tính toàn vẹn dữ liệu cho BI truyền thống, là yếu tố then chốt đằng sau sự tăng trưởng đột phá này. Data Lakehouse giải quyết thành công bài toán này bằng cách đưa khả năng quản trị đáng tin cậy vào tầng lưu trữ thô, biến nó thành nguồn dữ liệu đáng tin cậy duy nhất cho cả hai lĩnh vực quan trọng.

Các lợi ích nổi bật của Data Lakehouse

Kiến trúc Data Lakehouse mang lại nhiều lợi ích kinh tế và kỹ thuật, đại diện cho sự kết hợp tối ưu giữa “Best of Both Worlds”.

Tối ưu hóa chi phí sở hữu tổng thể

Data Lakehouse đạt được sự tối ưu chi phí đáng kể so với Data Warehouse truyền thống.

Giảm chi phí lưu trữ: Bằng cách xây dựng trên nền tảng Object Storage đám mây, Data Lakehouse giảm đáng kể chi phí lưu trữ cho các tập dữ liệu lớn so với các kho dữ liệu độc quyền, nơi chi phí lưu trữ có thể rất đắt.

Giảm chi phí vận hành: Kiến trúc này loại bỏ sự cần thiết của các hệ thống riêng biệt và các quy trình ETL/ELT phức tạp, từ đó giảm thiểu tình trạng dữ liệu dự phòng và chi phí quản lý vận hành hai hệ thống độc lập. Một số nghiên cứu đã chỉ ra khả năng giảm TCO phân tích tới hơn 50% so với việc sử dụng Data Warehouse truyền thống.

Mặc dù chi phí lưu trữ là thấp, TCO thực tế của Lakehouse lại phụ thuộc lớn vào việc quản lý chi phí tính toán. Nếu các mẫu truy vấn không được tối ưu hóa, công cụ tính toán sẽ phải quét lượng dữ liệu lớn hơn mức cần thiết, dẫn đến chi phí tính toán tăng vọt, đôi khi vượt quá chi phí DW truyền thống. Do đó, việc tối ưu hóa truy vấn thông qua các chiến lược như phân vùng thông minh là yếu tố quyết định để đạt được mức TCO thấp.

Hỗ trợ tác vụ hỗn hợp

Data Lakehouse được thiết kế để xử lý linh hoạt cả xử lý hàng loạt, vốn lý tưởng cho việc phân tích lịch sử quy mô lớn, và phân tích thời gian thực. Sự linh hoạt này cho phép doanh nghiệp đáp ứng nhiều nhu cầu kinh doanh đa dạng, từ việc tạo báo cáo hàng quý cho đến cung cấp thông tin chi tiết tức thời cho các quyết định vận hành.

Chất lượng dữ liệu và độ tin cậy cao

Nhờ việc áp dụng các định dạng Bảng Mở (OTFs) hỗ trợ giao dịch ACID, Data Lakehouse cung cấp độ tin cậy và tính nhất quán về dữ liệu tương đương với Data Warehouse. Ngoài ra, sự hiện diện của Lớp Siêu dữ liệu giúp duy trì thông tin lược đồ và đảm bảo tính khám phá của dữ liệu, từ đó cải thiện chất lượng tổng thể cho việc truy vấn. Cải thiện chất lượng dữ liệu là một trong những động lực chính thúc đẩy các tổ chức áp dụng kiến trúc này.

Khả năng mở rộng và tương tác cao

Data Lakehouse tận dụng Object Storage để cung cấp khả năng mở rộng lưu trữ gần như không giới hạn. Việc sử dụng các công nghệ mã nguồn mở như Apache Spark, Delta Lake, Apache Iceberg, và Apache Hudi cũng tăng cường khả năng tương tác và linh hoạt, đồng thời giảm thiểu rủi ro bị khóa nhà cung cấp ở tầng dữ liệu cốt lõi.

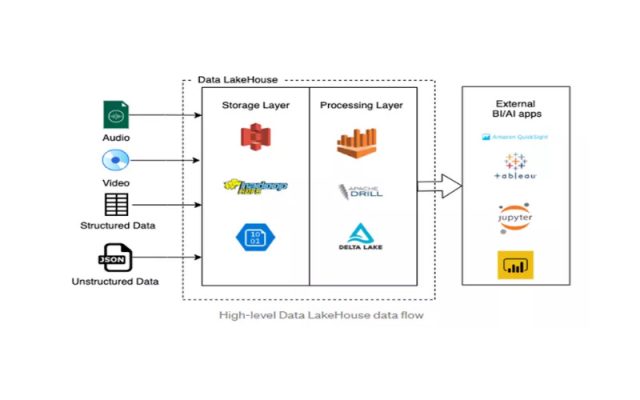

Kiến trúc của Data Lakehouse

Kiến trúc Data Lakehouse là một mô hình phân lớp hợp lý, được thiết kế để tách biệt chức năng lưu trữ và tính toán, đồng thời chèn một lớp quản lên trên Object Storage.

Mô hình kiến trúc phân lớp

Kiến trúc Data Lakehouse thường được mô tả thông qua mô hình năm lớp logic, mỗi lớp đảm nhận một vai trò cụ thể để đảm bảo quy trình dữ liệu toàn diện.

Lớp thu thập dữ liệu

Lớp này chịu trách nhiệm đưa dữ liệu vào Lakehouse từ các nguồn khác nhau (cơ sở dữ liệu, ứng dụng, nhật ký, dữ liệu bên ngoài). Lớp thu thập phải có khả năng kết nối đa dạng và xử lý cả dữ liệu hàng loạt và dữ liệu thời gian thực vào kho lưu trữ.

Lớp lưu trữ

Đây là nền tảng vật lý của Lakehouse. Lớp này sử dụng giải pháp lưu trữ đối tượng chi phí thấp trên đám mây để lưu trữ khối lượng lớn dữ liệu thô. Dữ liệu được tổ chức dưới định dạng Columnar (như Parquet, ORC, Avro), tối ưu cho các truy vấn phân tích quy mô lớn.

Lớp giao dịch và siêu dữ liệu

Đây là trái tim kỹ thuật của Lakehouse, cung cấp các tính năng quản trị. Lớp này bao gồm các Định dạng Bảng Mở (OTFs) như Delta Lake, Iceberg, hoặc Hudi. Nó quản lý các giao dịch ACID, duy trì thông tin lược đồ, hỗ trợ time-travel và đảm bảo khả năng khám phá dữ liệu.

Lớp tính toán và API

Lớp này chứa các công cụ xử lý phân tán (như Apache Spark, Trino, Flink) được sử dụng để làm sạch, chuẩn hóa, chuyển đổi dữ liệu, và thực hiện các phân tích phức tạp. Nó cung cấp các giao diện tiêu chuẩn (như SQL) để các ứng dụng có thể truy vấn dữ liệu hiệu quả.

Lớp tiêu thụ

Lớp đầu cuối này kết nối trực tiếp Data Lakehouse với các công cụ nghiệp vụ, bao gồm các công cụ Phân tích Kinh doanh (BI Tools – Power BI, Tableau), các môi trường Khoa học Dữ liệu (Data Science) và các Framework Học máy (ML Frameworks).

Định dạng Bảng Mở (Open Table Formats – OTFs)

Các Định dạng Bảng Mở (OTFs) là công nghệ cầu nối quan trọng, hoạt động như một lớp siêu dữ liệu trên các tệp dữ liệu vật lý (thường là Parquet), mang lại các tính năng của hệ thống quản lý cơ sở dữ liệu (DBMS) tiêu chuẩn.

Delta Lake

Ban đầu được phát triển bởi Databricks, Delta Lake sử dụng một Transaction Log (Delta Log) tuần tự, phụ thuộc vào việc ghi nối tiếp (append-only), để quản lý tính nhất quán giao dịch và các hoạt động siêu dữ liệu. Delta Lake tối ưu hóa cho các môi trường Databricks và các khối lượng công việc kết hợp giữa xử lý hàng loạt và xử lý trực tuyến.

Apache Iceberg

Được thiết kế để quản lý siêu dữ liệu quy mô lớn, Apache Iceberg nổi bật với khả năng tương tác đa-engine vượt trội, cho phép các công cụ khác nhau (như Trino, Spark, Snowflake, Google BigQuery) truy vấn cùng một dữ liệu một cách hiệu quả ở quy mô petabyte. Iceberg hỗ trợ đầy đủ các tính năng nâng cao như ACID, time travel, và đặc biệt là partition evolution (khả năng thay đổi cách phân vùng bảng theo thời gian).

Apache Hudi

Hudi (Hadoop Upserts Deletes and Incrementals) xuất sắc trong các đường ống streaming yêu cầu tải dữ liệu thay đổi liên tục (Change Data Capture – CDC) và các môi trường cần cập nhật hoặc xóa thường xuyên. Cộng đồng Hudi gọi công nghệ của họ là Hệ thống Quản lý Data Lakehouse (DLMS), tập trung vào các thành phần quản lý vượt trội, bao gồm cả việc tối ưu hóa quản lý metadata để tra cứu nhanh hơn.

Triển khai theo kiến trúc Medallion

Để đảm bảo chất lượng và độ tin cậy của dữ liệu khi di chuyển qua Lakehouse, mô hình Kiến trúc Medallion (Medallion Architecture) là một mẫu hình tổ chức dữ liệu phổ biến.

Bronze Layer

Chứa dữ liệu thô, không thay đổi, được ghi trực tiếp sau quá trình thu thập (ingestion).

Silver Layer

Dữ liệu đã được làm sạch, lọc, chuẩn hóa và tích hợp từ nhiều nguồn. Lớp này áp dụng lược đồ (schema) và là nơi thực hiện các kiểm tra chất lượng dữ liệu tự động. Dữ liệu trong tầng Silver được coi là dữ liệu đáng tin cậy.

Gold Layer

Dữ liệu được tổng hợp, biến đổi và tối ưu hóa thành các mô hình bảng (data marts) phục vụ trực tiếp cho các trường hợp sử dụng cụ thể của doanh nghiệp (ví dụ: báo cáo BI, dashboard, tính toán chỉ số KPI).

Ứng dụng của Data Lakehouse trong doanh nghiệp

Data Lakehouse là một kiến trúc chiến lược được các Giám đốc Công nghệ (CTO) sử dụng để biến dữ liệu lớn thành tài sản hoạt động, phục vụ trực tiếp các mục tiêu kinh doanh.

Ngành tài chính và ngân hàng

Trong lĩnh vực tài chính, việc hợp nhất dữ liệu giao dịch có cấu trúc với dữ liệu phi cấu trúc (ví dụ: nhật ký hệ thống, dữ liệu tương tác từ ứng dụng di động) trong Data Lakehouse cho phép phân tích hành vi khách hàng và giao dịch theo thời gian thực.

Phát hiện gian lận: Ngân hàng sử dụng Lakehouse để xây dựng các mô hình học máy theo dõi các giao dịch thời gian thực, kết hợp với các dữ liệu lịch sử và dữ liệu tương tác để nhanh chóng xác định các kiểu hành vi gian lận ngay lập tức, từ đó giảm thiểu đáng kể tổn thất.

Tuân thủ quy định: Hợp nhất tất cả các loại dữ liệu, bao gồm cả tài liệu quy định và dữ liệu báo cáo, trên một nền tảng được quản trị thống nhất giúp đơn giản hóa việc kiểm toán và tuân thủ các yêu cầu pháp lý nghiêm ngặt.

Ngành bán lẻ và thương mại điện tử

Các tập đoàn thương mại điện tử tận dụng Data Lakehouse để đạt được khả năng cá nhân hóa khách hàng sâu sắc và tối ưu hóa chuỗi cung ứng.

Cá nhân hóa khách hàng: Dữ liệu bán hàng có cấu trúc được kết hợp với dữ liệu phi cấu trúc khối lượng lớn, chẳng hạn như nhật ký clickstream thô, dữ liệu mạng xã hội và hình ảnh sản phẩm. Dữ liệu này được làm sạch và chuẩn hóa (tầng Silver), sau đó được sử dụng để huấn luyện mô hình ML (tầng Gold) dự đoán xu hướng sản phẩm, tối ưu hóa tồn kho, hoặc dự đoán tỷ lệ khách hàng bỏ đi (churn).

Ví dụ thực tế: Một công ty có thể sử dụng dữ liệu clickstream thô để làm sạch, chuẩn hóa thành các bảng khách hàng và sản phẩm, sau đó sử dụng các bảng này để chạy các thuật toán dự đoán nhu cầu, cung cấp khả năng query bằng SQL cho Business Analyst và sử dụng cùng dataset đó cho Data Scientist.

Hy vọng qua bài viết này, bạn đã hiểu rõ Data Lakehouse là gì, cách thức hoạt động cũng như lợi ích mà mô hình này mang lại cho doanh nghiệp trong việc quản lý và khai thác dữ liệu. Có thể thấy, Data Lakehouse không chỉ kết hợp ưu điểm của Data Lake và Data Warehouse mà còn mở ra hướng tiếp cận linh hoạt, tiết kiệm chi phí và hiệu quả hơn trong chiến lược dữ liệu của doanh nghiệp.

Như vậy, đầu tư vào nền tảng Data Lakehouse chính là bước đi chiến lược giúp doanh nghiệp tối ưu hạ tầng, nâng cao khả năng phân tích và sẵn sàng cho các ứng dụng AI, Machine Learning trong tương lai.